Datakeskusten infrastruktuurin kehittämisessä ollaan tällä hetkellä vaikean yhtälön äärellä. Kapasiteettitarve kasvaa, tehotiheys nousee ja olemassa olevat tilat on usein mitoitettu menneen aikakauden kuormille. Jos perustan skaalautuvuutta ja riskien hallintaa ei ole mietitty jo rakennusvaiheessa, seuraavana edessä voivat olla kalliit lisäinvestoinnit, jotta laitetila saadaan vastaamaan tämän päivän vaatimuksia.

Miten AI- ja GPU-kuormat muuttavat datakeskuksen kapasiteettia?

Modernin liiketoiminnan ytimessä ovat sovellukset, jotka vaativat yhä enemmän datankäsittelykapasiteettia ja nopeaa, luotettavaa tiedonsiirtoa. Tekoäly, edge computing, reaaliaikainen prosessointi ja kvanttilaskennan ensimmäiset sovellukset kiristävät vaatimuksia riippumatta siitä, onko kyse teollisuusautomaatiosta, puolustuksen järjestelmistä vai datakeskusten kuormanhallinnasta.

Samalla yksittäisten laitekaappien tehot ovat moninkertaistuneet: perinteinen 5–10 kW kaappikohtainen taso on monessa hankkeessa vaihtunut 30–40 kW:iin, ja tietyissä erikoistapauksissa varaudutaan jopa satojen kilowattien kaappeihin. Se, mihin aiemmin tarvittiin sata kaappia ja kokonainen sali, voidaan nykyteknologialla toteuttaa ehkä kahdessakymmenessä–neljässäkymmenessä kaapissa.

Tämä näkyy konkreettisesti siinä, miten olemassa olevat tilat alkavat rajoittaa kapasiteettia. Sali, johon on suunniteltu 500 kaappia, riittääkin nykyisillä tehotiheyksillä ehkä noin sadalle kaapille. Loppu lattiapinta jää vajaakäytölle: neliöitä olisi, mutta sähkö ja jäähdytys eivät riitä.

Kapasiteettia ja siihen liittyviä riskejä on siksi järkevää tarkastella koko datakeskuksen elinkaaren yli: jo suunnitteluvaiheessa on päätettävä, mihin kehitystarpeisiin halutaan varautua ja mitkä osat infrasta mitoitetaan kerralla riittävän suuriksi. Moni ratkaisu on lopulta edullisempaa tehdä hieman ylimitoitettuna rakennusvaiheessa kuin uusia myöhemmin kokonaan raskailla lisäinvestoinneilla.

“Olen nähnyt kohteita, joissa lattiapintaa jää käyttämättä, koska jäähdytys ja sähkönjakelukapasiteetti ei riitä ja kapasiteetin kasvattaminen vaatii liian korkeita investointeja.”

– Sami Salmela, Orbiksen datakeskusasiantuntija

Investointivaiheen ratkaisut ja riskienhallinta määrittävät konesalin elinkaaren hinnan

Sähköliittymän koko, virranjakelun toteutus ja jäähdytyslaitteisto muodostavat katon sille, mitä salissa voidaan tehdä. Jos perusjärjestelmä on mitoitettu 10 megawatin IT-kuormalle, seuraava megawatti ei välttämättä ole pieni hienosäätö, vaan projekti, joka vaatii muutoksia liittymään, jakeluun ja jäähdytysjärjestelmiin.

Jäähdytyksen kohdalla olennaista on:

- Onko jäähdytyslaitteiden kapasiteettia mahdollista kasvattaa?

- Onko putkireitit suunniteltu kasvaville vesimäärille?

- Onko näitä päivityksiä mahdollista toteuttaa tilan käytön puolesta?

Sama koskee sähköä: kiinteistön sähköliittymän koko määrittää käytettävissä olevan kapasiteetin eikä sitä voida kasvattaa ilman sähköliittymän päivittämistä. Tulevia kuormia on vaikea arvioida tarkasti, mutta suunta on selvä. GPU-tekoälysuorittimet kuluttavat moninkertaisesti sähköä verrattuna perinteisiin palvelimiin ja tämä kasvattaa kaappikohtaista tehoa. Kyse ei ole vain tekniikasta, vaan myös taloudellisesta riskienhallinnasta: miten pitkälle nykyinen ratkaisu kantaa ennen seuraavaa kallista muutosta.

Suunnittelu- ja rakennusvaiheessa on hyvä miettiä, miten tuleviin laajennustarpeisiin varaudutaan. Mitoitetaanko ja toteutetaanko jokin osa ylimitoitettuna niin, että se kestää tulevan laajennustarpeen, vai tehdäänkö tarpeelliset muutokset vasta sitten kun niitä oikeasti tarvitaan. Kaikkea ei ole tarkoituksenmukaista rakentaa kerralla valmiiksi, mutta tietyt perusasiat on hyvä miettiä elinkaaren ja riskinhallinnan näkökulmasta.

Sähköjakeluun, jäähdytykseen sekä muihin teknisiin ratkaisuihin kannattaa jättää pelivaraa, jos on pienikin mahdollisuus, että kaappikohtaista tehoa tai AI-kuormaa halutaan kasvattaa. Näin investoinnit tukevat hallittua modernisointia sen sijaan, että pakottavat tekemään hätäisiä ratkaisuja myöhemmin.

Energiatehokkuuden ja jäähdytyksen käytännön keinoista voit lukea tarkemmin artikkelissamme “Energiatehokas datakeskus Suomessa – 4 käytännön vinkkiä laitetilan suunnitteluun tulevaisuutta varten”.

AI- ja GPU-klusterien vaikutus datakeskuksen kaapelointiin

Kaapelointi ei yleensä ole ensimmäinen megawattien kasvua rajoittava tekijä, mutta sen merkitys korostuu, kun infraa tarkastellaan useamman laitesukupolven yli. AI- ja GPU-klustereissa laskentateho keskittyy harvempiin, raskaampiin kaappeihin, jolloin yksittäisen kaapin kuitunopeudet kasvavat, mutta kokonaisuus pysyy hallittuna, jos arkkitehtuuri ja nopeustasot on päivitetty tähän päivään. Samat kuitureitit ja paneelit voivat palvella pitkään, kun ne on alun perin suunniteltu kestämään sekä nopeuksien että kuormien muutosta.

AI- ja GPU-ympäristöissä haaste ei ole vain kuitumäärässä, vaan hallittavuudessa. Yhdessä kaapissa voi olla kymmeniä tai satoja kilowatteja tehoa ja useita 400G/800G-yhteyksiä. Jos kaapelointi on kasvanut kerros kerrokselta, topologiaa on vaikea laajentaa ilman katkoksia. Siksi arkkitehtuuri ratkaisee: mihin keskitetään, miten jaellaan, miten laajennetaan. Hyvin suunniteltu fyysinen kerros toimii samalla riskienhallinnan välineenä: muutokset voidaan tehdä vaiheittain ilman, että koko verkko joudutaan avaamaan kerralla.

Monessa kohteessa taustalla on edelleen OM3-tyyppistä monimuotokuitua, joka on aikanaan riittänyt hyvin. Kun 10 ja 40 Gbit/s -yhteyksistä on haluttu siirtyä 100 ja 400 Gbit/s tasolle ja etäisyydet ovat kasvaneet, raja on tullut vastaan. Yksimuotokaapelointi nähdään yhä useammin tapana jatkaa elinkaarta: sama runko voi palvella useampaa laitesukupolvea ilman, että kaikki vedot tehdään uudestaan. Modulaariset paneelit ja valmiskaapelointi tukevat tätä ajattelua.

OM-siirtymää teollisuudessa käsittelemme tarkemmin artikkelissamme “OM1-teknologiasta siirtyminen uudempiin versioihin”.

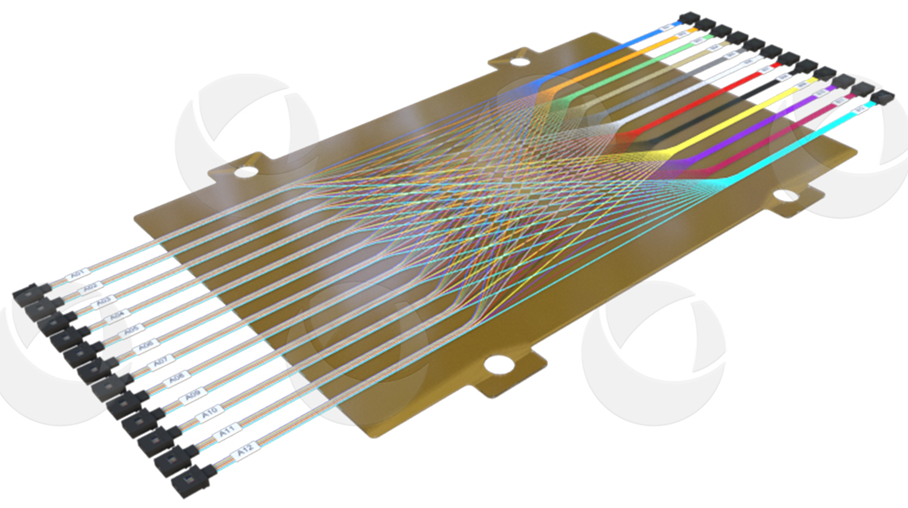

AI/ML-klustereissa tiheiden kuitumäärien ja monimutkaisten topologioiden hallintaan käytetään usein shuffle-ratkaisuja. Passiiviset shuffle-boxit ja monikuituiset shuffle-kaapelit kokoavat optiset yhteydet yhteen pisteeseen, josta ne voidaan jakaa hallitusti useille kytkimille ja palvelimille. Tämä helpottaa laajennuksia ja muutoksia, nopeuttaa asennuksia, vähentää virheiden riskiä ja pitää kaapeloinnin rakenteen selkeänä, vaikka GPU-klusterit kasvavat.

Oikein suunniteltu kaapelointi vähentää turvallisuus- ja kapasiteettiriskejä datakeskuksessa

Kaapeloinnin rooli ulottuu sekä turvallisuuteen että tulevaan kvanttiturvallisuuteen. Optinen siirto, kytkimien arkkitehtuuri ja se, missä kohtaa signaali muunnetaan ja jaetaan, vaikuttavat suoraan tiedonsiirron eheyteen – ja siten myös siihen, millaisia riskejä dataliikenteen suojaamiseen ja valvontaan liittyy. Kun perusinfra rakennetaan selkeisiin optisiin reitteihin ja MPO/MTP-tyyppisiin ratkaisuihin nojaavaksi, sekä siirtymä kvanttiturvallisiin ratkaisuihin että arjen ylläpito on helpompi toteuttaa ilman, että koko fyysistä selkärankaa tarvitsee purkaa.

Kun runkoreitit ja niput suunnitellaan hallituiksi, kaapelointi ei tuki ilmankiertoa ja tilaa jää paremmin jäähdytykselle ja huollolle – tärkeä etu silloin, kun kaappikohtaiset tehot kasvavat. Sähkö, jäähdytys ja kaapelointi muodostavatkin käytännössä yhden kapasiteettipolun: jos yksikin osa mitoitetaan vanhan maailman oletuksilla, se alkaa rajoittaa sekä datakeskuksen kehitystä että tulevien investointien vaihtoehtoja ja kasvattaa kapasiteetti- ja käyttökatkoriskejä.

Laajemmin datakeskuksen fyysisestä ja loogisesta turvallisuudesta kerromme artikkelissamme “Datakeskuksen turvallisuuden takaa huolella suunniteltu kokonaisuus.”

Näin teet järjestelmällisen suunnitelman datakeskuksen kapasiteetin modernisoimiseksi

Moni datakeskusjohtaja katsoo tällä hetkellä olemassa olevaa saliaan ja pohtii, voiko siitä modernisoimalla rakentaa nykyisen AI- ja analytiikkakuorman kestävän ympäristön. Hyvä tapa edetä on purkaa tilanne muutamaan selkeään vaiheeseen.

1. Kartoitetaan nykytila

Kuinka paljon jäähdytystehoa on todellisuudessa käytettävissä? Millainen sähköliittymä ja jakelu salissa on? Miten kaapelointi ja reitit on toteutettu, ja miten tila on jaettavissa eri moduuleihin? Tässä vaiheessa on tärkeää saada numerot pöydälle: paljonko tehoa voidaan syöttää kaappia kohden, miten ilmankierto toimii ja missä näkyvät ensimmäiset pullonkaulat.

2. Määritellään tavoite

Kuinka korkeaksi salin tehotiiveys halutaan kasvattaa ja millaisella aikataululla? Kun kaappikohtainen teho on tiedossa, voidaan laskea kaappien enimmäismäärä salissa infran kapasiteetin rajoissa. Samalla voidaan arvioida, mitkä ovat todennäköiset rajoittavat tekijät mahdollisille tulevaisuuden laajennustarpeille.

3. Tehdään mitoitus

Lasketaan, millaista sähkö- ja jäähdytyskapasiteettia tavoitetila edellyttää, ja verrataan sitä nykytilaan. Samalla arvioidaan, riittävätkö nykyiset kaapelireitit ja kuitu uuteen kapasiteettitasoon vai tarvitaanko muutoksia runkoverkon topologiaan tai paneelivaihtoehtoihin. Näin muodostuu kuva siitä, mitä voidaan säilyttää, mitä päivittää ja mitä on järkevää rakentaa uusiksi.

4. Skenaariot ja budjettitasoiset arviot

Yksi vaihtoehto on hyödyntää nykyistä infraa mahdollisimman pitkälle, toinen on rakentaa rinnakkainen järjestelmä osaan salia ja kolmas suunnitella kokonaan uusi moduuli tai keskus. Jokaiselle skenaariolle lasketaan karkea kustannus ja vaikutus kapasiteettipolkuun. Näin päätöksentekijä näkee, mitä eri vaihtoehdot käytännössä tarkoittavat, eikä joudu reagoimaan irrallisiin hankintapyyntöihin tapaus kerrallaan.

Datakeskuksen suunnittelussa pätevät kriittisen tiedonsiirron periaatteet

Ympäristöissä, joissa yhteys ei saa katketa ja käyttökatkojen ikkunat ovat hyvin rajallisia, korostuvat samat periaatteet: elinkaari, huollettavuus, huoltovarmuus ja kyky mukautua tuleviin vaatimuksiin. Pohjimmiltaan kyse on järjestelmällisestä suunnitelmasta, joka sitoo sähkönsyötön, jäähdytyksen ja tiedonsiirron yhdeksi kokonaisuudeksi.

Orbis on rakentanut ratkaisuja vuosikymmenten ajan pienistä laitetiloista suuriin konesalikokonaisuuksiin sekä kriittisistä tehdasverkoista puolustusteollisuuden sovelluksiin. Kokemusta on kertynyt tilanteista, joissa vanhoja OM1-verkkoja on päivitetty yksimuotokuituun, optisia runkoverkkoja on suunniteltu kvanttikautta silmällä pitäen ja infraa on sovitettu ääriolosuhteisiin, joissa lämpötila, tärinä ja sähkömagneettiset häiriöt asettavat omat reunaehtonsa. Tämän ansiosta tunnemme sekä datakeskusten käyttäjien arjen että uusimmat, toimintavarmat teknologiat.

Kun tämä ajattelu tuodaan datakeskukseen, lopputuloksena syntyy selkäranka, joka tukee sekä tämän päivän AI- ja edge-kuormia että seuraavaa teknologiasukupolvea. Autamme sinua rakentamaan investointisuunnitelman ja ratkaisukokonaisuuden, joka kantaa seuraavaa laitesukupolvea pidemmälle ja tukee datakeskuksesi pitkäjänteistä riskienhallintaa.